数十年来,机器已经能够理解简单的音乐功能,例如每分钟的节拍数。现在,人工智能正在将他们的能力提高到一个点,即他们不仅可以弄清楚正在播放的音乐的特定类型,还可以弄清楚如何适当地跳舞。

显然,EDM俱乐部中的舞蹈风格与人们在酒店宴会厅中跳动的方式大不相同。即使您不是乡村音乐的狂热者,当您听到怀旧的“乡村小路”合唱时,您的脚也可能会轻拍并且摇摇头。我们的身体对各种音乐刺激的反应几乎是本能的-如何将其教给机器?

加利福尼亚大学,默塞德大学和NVIDIA大学的研究人员引入了一种通过分析进行综合的学习框架Music2Dance,该框架可以为不同音乐流派产生“风格一致且节拍匹配的舞蹈”。这项工作将于下个月在温哥华的NuerIPS 2019上发表。

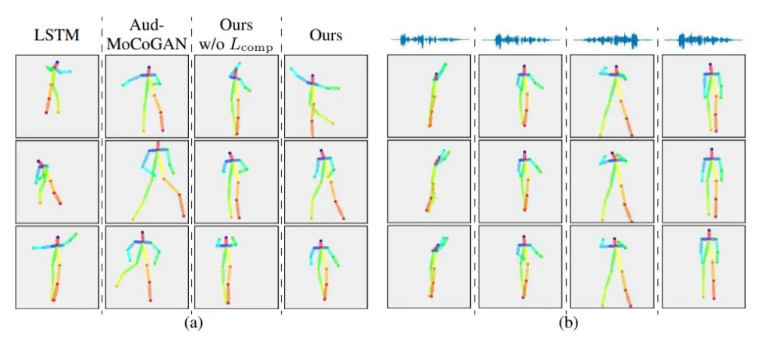

研究人员介绍了一种新颖的分解到合成框架,该框架可以将基本的身体动作转化为以音乐为条件的复杂舞蹈。分解阶段通过运动节拍检测器定义和标准化从真实舞蹈序列视频中分割的舞蹈单元,学习如何执行基本的舞蹈动作。在作曲阶段,音乐对运动的生成对抗网络(GAN)生成以音乐为条件的舞蹈动作。研究人员然后提取样式和节拍,以循环的方式合成舞蹈单元,并对所生成的舞蹈单元序列应用“节拍整经器”以渲染最终的输出舞蹈。

研究人员将其分解到合成框架与LSTM和Aud-MoCoGAN等基准进行了比较,这些指标包括运动逼真度,样式一致性,多样性,多模式性,拍子覆盖率和命中率。研究人员提出的框架产生的舞蹈更加逼真,多样,并且与音乐的同步性更好。今年早些时候,麻省理工学院CSAIL还对音频和视频之间的跨模式学习进行了有趣的研究。在他们的论文《Speech2Face:学习声音背后的脸》中,研究人员设计并训练了一个深度神经网络,以根据人们的短语音录音来重建人们的面部图像。

尽管AI研究人员通常不被称为派对动物,但他们似乎确实对舞蹈充满热情。Synced于10月发布了故事《摇动你的赃物:一张照片中的AI深度假装舞步》,该报道报道了上海科技大学和腾讯AI实验室研究人员的3D身体网格恢复模块Liquid Warping GAN,它可以从一张照片中将假舞步深化。这篇论文介绍了这项研究液体翘曲GAN:模仿人体运动,外观转移和新颖视图合成的统一框架。

教育新闻网

教育新闻网